3 Minuten

Musikalische Darbietungen sind ein komplexer Kommunikationsprozess zwischen Interpreten und Publikum, aber bis jetzt haben wir nicht vollständig verstanden, wie emotionale Botschaften vom Musiker zum Zuhörer gelangen. Neue Forschungsarbeiten, die Audioanalyse, Echtzeit-Emotionsverfolgung und Gehirnüberwachung von Solo-Instrumentalisten kombinieren, haben die Mechanismen hinter dieser musikalischen Kommunikation aufgedeckt - und die Ergebnisse stellen gängige Annahmen über Aufführungen in Frage.

Die Feststellung der Aussagekraft

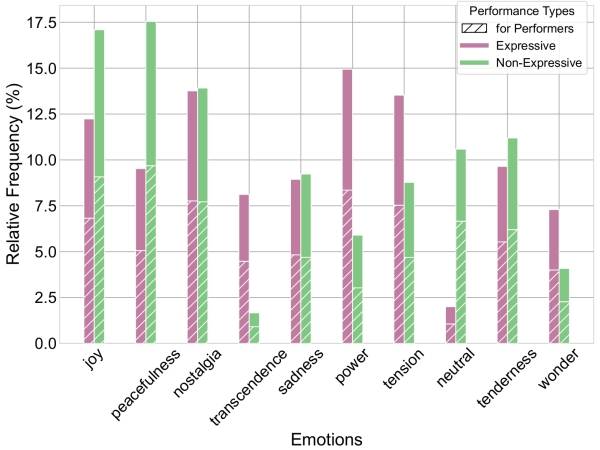

Die wichtigste Erkenntnis: Ausdrucksstarke und improvisierte Darbietungen schaffen eine stärkere emotionale Verbindung zwischen Interpreten und Publikum als technisch akkurates, aber nicht-expressives Spiel. Wenn Musiker die gleichen Stücke sowohl expressiv als auch nicht-expressiv spielten, war die emotionale Trennung messbar. Die statistische Analyse zeigte, dass die Absichten der Interpreten und die Wahrnehmung des Publikums bei nicht-expressiven Darbietungen erheblich voneinander abweichen, während bei expressiven und improvisierten Bedingungen eine hohe emotionale Übereinstimmung erzielt wurde.

Hier geht es nicht nur um die Vorlieben des Publikums, sondern um die erfolgreiche Übertragung von Emotionen. Bei expressiven Darbietungen traten Emotionen mit hoher Erregung wie Macht und Spannung und Emotionen mit hoher Wertigkeit wie Transzendenz stärker in den Vordergrund, während neutrale Reaktionen nahezu verschwanden.

Distribution of reported emotions. Comparison between Expressive and Non-Expressive performances.

An example of the music track Greensleeves played in an expressive manner.

And non-expressive manner:

Die akustische Signatur der Verbindung

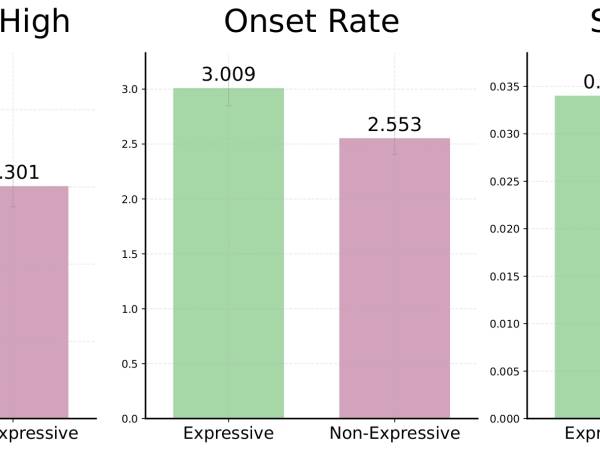

Was macht eine ausdrucksstarke Darbietung aus? Eine Audioanalyse von über 200 Aufnahmen ergab drei akustische Merkmale, die ausdrucksstarkes von nicht ausdrucksstarkem Spiel unterscheiden:

Anschlagstärke: Ausdrucksstarke Darbietungen zeichnen sich durch schärfere, entschlossenere Anschläge aus. Dies sorgt für eine klarere Artikulation, die dem Publikum hilft, der emotionalen Erzählung zu folgen.

Einsetzgeschwindigkeit: Bei ausdrucksstarkem Spiel treten Noten häufiger auf, was nicht unbedingt ein schnelleres Tempo bedeutet, sondern eine nuanciertere rhythmische Aktivität, die das Interesse des Zuhörers aufrechterhält.

Spektralfluss: Größere Klangvariationen – also die Veränderung der Klangfarbe im Laufe der Zeit – liefern dem Publikum reichhaltigere emotionale Informationen, die es verarbeiten kann.

Improvisationen wiesen von allen Spielarten die höchsten Anschlagsflanken auf, was darauf hindeutet, dass spontane Kreationen diese engagementfördernden Merkmale von Natur aus enthalten.

Comparison of statistically significant acoustic features. Analysis between Expressive and Non-Expressive performances.

Technologie liest musikalische Emotionen

Mit diesen Daten trainierte Modelle für maschinelles Lernen erzielten eine bemerkenswerte Genauigkeit bei der Vorhersage emotionaler Reaktionen. Die Modelle zeigten, dass friedliche Emotionen mit einer geringen spektralen Flachheit und minimalen Frequenzschwankungen korrelieren – im Wesentlichen werden stabile, tonale Klänge sowohl von den Interpreten als auch von den Zuhörern als beruhigend empfunden.

Interessanterweise wiesen die Entscheidungsbäume der Interpreten und des Publikums unterschiedliche Komplexitätsgrade auf. Die Emotionsvorhersagen der Interpreten basierten stark auf spektralen Merkmalen und ihrem eigenen physiologischen Zustand, während das Publikum breitere akustische Informationen wie Pulsfrequenz und spektrale Komplexität verarbeitete.

Gehirnaktivität verrät kreative Zustände

Die EEG-Überwachung ergab, dass Improvisation eindeutige neuronale Signaturen erzeugt. Die Alpha-Gehirnwellenaktivität, die mit Kreativität und der Hemmung konventioneller Ideen in Verbindung gebracht wird, zeigte während Improvisationsdarbietungen den geringsten Rückgang gegenüber dem Ruhezustand. Dies deutet darauf hin, dass improvisierende Musiker in einen entspannteren, kreativ offeneren Geisteszustand eintreten, den das Publikum wahrnehmen kann.

Praktische Anwendungen

Für Interpreten: Konzentrieren Sie sich auf die Klarheit des Anschlags, rhythmische Nuancen und Klangvielfalt statt nur auf technische Genauigkeit. Die Daten zeigen, dass emotionale Absichten in messbare akustische Veränderungen umgesetzt werden, die das Publikum wahrnimmt.

Die im Rahmen des witheFlow-Projekts durchgeführte Studie, das KI-Systeme zur Verbesserung des menschlichen Ausdrucks in der Musik entwickelt, zeigt, dass emotionale Kommunikation in der Musik vorhersehbaren Mustern folgt. Dies eröffnet Möglichkeiten für ein verbessertes Training und für Technologien, die Musikern helfen können, eine bessere Verbindung zum Publikum herzustellen.

Die Auswirkungen gehen über die Spieltechnik hinaus. Das Verständnis dieser Mechanismen könnte Musiktherapieanwendungen verbessern, Kompositionsstrategien beeinflussen und die Musikausbildung durch objektive Messgrößen für expressive Kommunikation bereichern.

witheFlow project

Musical emotion isn't mystical—it's measurable, teachable, and now, predictable.

Danksagungen

Das witheFlow-Projekt wird im Rahmen des H.F.R.I-Aufrufs „Grundlagenforschung (horizontale Förderung aller Wissenschaften)” unter dem nationalen Konjunktur- und Resilienzplan „Greece 2.0” durchgeführt, der von der Europäischen Union – NextGenerationEU finanziert wird. Wir danken den Teilnehmern des Publikums, die diese Arbeit ermöglicht haben.

Dieser Artikel von Vassilis Lyberatos und Spyridon Kantarelis ist Teil der Auswahl von Beiträgen für die SMC25 – Sound and Music Computing Conference & Summer School, die vom 7. bis 12. Juli 2025 in Graz stattfindet.

Vassilis Lyberatos & Spyridon Kantarelis

Vassilis Lyberatos ist Doktorand im Labor für künstliche Intelligenz und lernende Systeme der NTUA. Er spezialisierte sich auf Informatik an der Fakultät für Elektrotechnik und Computertechnik der NTUA. Seine Forschungsinteressen umfassen erklärbare KI, maschinelles Lernen, Wissens- und Graphendarstellung, Music Information Retrieval, Neurowissenschaften und andere verwandte Gebiete. Er nahm an europäischen und griechischen KI-Projekten teil und absolvierte einen Forschungsaufenthalt bei DTU Compute. Außerdem unterstützt er die Lehre und ist als Gutachter auf internationalen Konferenzen und in Fachzeitschriften tätig.

Spyridon Kantarelis ist Doktorand am NTUA's AI and Learning Systems Lab. Seine Bachelorarbeit lautete "Ontologie- und Algorithmenentwicklung für die harmonische Analyse von musikalischen Akkordfolgen". Seine derzeitige Forschung dreht sich um die Anwendungen der Künstlichen Intelligenz im Bereich der Musik, insbesondere um die automatische Musikanalyse unter Verwendung symbolischer Musikdaten. Zu seinen Forschungsinteressen gehören Music Information Retrieval, Knowledge Representation and Reasoning und Ontology Engineering. Er studierte fortgeschrittene Musiktheorie und Akkordeon am Nationalen Konservatorium von Athen.

Artikelthemen

Artikelübersetzungen erfolgen maschinell und redigiert.

Vassilis Lyberatos

Vassilis Lyberatos  Spyridon Kantarelis

Spyridon Kantarelis