6 Minuten

Ein historischer Überblick über die computergestützte Musikanalyse

Schon die Pioniere der Computermusik erkannten, dass Algorithmen das Potenzial haben, Klänge sowohl zu synthetisieren als auch zu analysieren, was sich beispielsweise in den aufschlussreichen Schriften von Otto Laske (Laske, 1981; 1991) manifestiert. Aus Laskes Kreis der Musikingenieure gingen Techniken wie die Spektralanalyse hervor, mit denen komplexe Klänge in ihre einzelnen Frequenzen zerlegt werden konnten. Diese wurden seit der Entwicklung der digitalen Signalverarbeitung (DSP) in der zweiten Hälfte des 20. Jahrhunderts zu einem grundlegenden Bestandteil der computergestützten Musikwissenschaft und demokratisierten diese Werkzeuge weiter, sodass es möglich wurde, eine Vielzahl von Merkmalen aus Audiodaten zu extrahieren, ohne dass teure Laborgeräte erforderlich waren. Dies führte zur Entwicklung von Python-Bibliotheken wie LibROSA (https://librosa.org/doc/latest/index.html), die ein robustes Framework für die Audioanalyse bieten und auch in Fällen nützlich sind, in denen elektroakustische Musik als akusmatisches Werk betrachtet wird. Die zeitgenössische Integration großer Sprachmodelle (LLMs) wie Googles Gemini in die Analyse von Daten, die mit Tools wie LibROSA gewonnen wurden, ermöglicht nicht nur die Datenextraktion, sondern auch eine differenzierte, kontextbezogene Interpretation musikalischer Phänomene.

SEMA – Ein Versuch, die mühsame Datenerfassung und -interpretation zu automatisieren

Das Hauptziel, das ich mit dem Schreiben des Skripts für SEMA verfolgte, war es, eine Möglichkeit zu finden, das Problem zu lösen, dass man tagelang mit einer einzigen Audiodatei beschäftigt ist, nur um Rohdaten für die Analyse zu extrahieren. Als Professor an der Akademie musste ich dies tun, um meine eigene Forschung voranzutreiben und auch um es im Unterricht mit Studenten zu verwenden, von denen die meisten keine Vorkenntnisse in solchen Analysen hatten. Da ich in kurzer Zeit eine große Menge an Musik und Klängen verarbeiten musste, versuchte ich, ein Hilfswerkzeug zu entwickeln, mit dem sich elektroakustische Musik automatisch und mit einem zufriedenstellenden Maß an Genauigkeit und Nützlichkeit quantitativ und eingehend analysieren lässt. Im Allgemeinen nutzt SEMA etablierte Audioverarbeitungstechniken und erweitert sie um die Interpretationsfähigkeit künstlicher Intelligenz. Ich wurde durch mehrere aktuelle Veröffentlichungen zu diesem Thema (siehe Literaturverzeichnis) dazu inspiriert, ähnliche Methoden zu verwenden und zu versuchen, sie in einen automatisierten Prozess mit Python und Open-Source-Tools anstelle einer speziellen Software wie MAX zu integrieren. Ich habe auch Gemini zur Unterstützung beim Codieren und Kommentieren des Codes verwendet, da es sowohl für Studienzwecke als auch für den praktischen Einsatz gedacht war.

Kernfunktionalität:

Die Verarbeitung beginnt mit dem Laden der .wav-Audiodatei und dem Resampling auf eine standardisierte Abtastrate (22050 Hz). Dies gewährleistet Konsistenz und optimiert die Leistung für die anschließende Merkmalsextraktion. Anschließend folgt der Abschnitt zur Merkmalsextraktion, in dem wichtige klangliche Eigenschaften über die Zeit quantifiziert werden. Das Skript extrahiert:

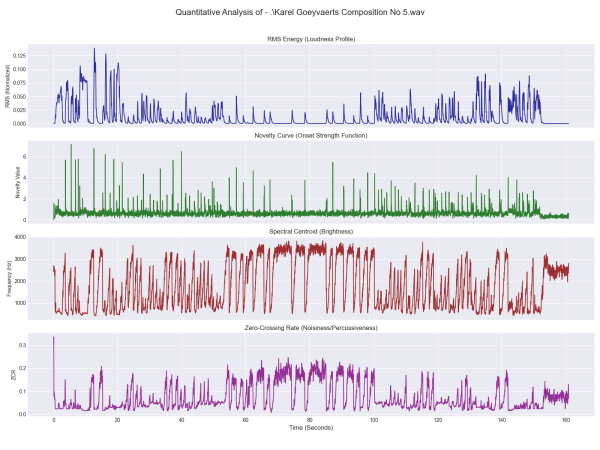

RMS-Energie: Root Mean Square Energy, ein Maß für die Gesamtlautstärke oder Intensität des Klangs.

Spektralzentrum: Stellt den Massenmittelpunkt des Spektrums dar und liefert einen Indikator für die wahrgenommene Helligkeit oder Schärfe des Klangs. Höhere Werte deuten auf eine hellere Klangfarbe hin.

Spektraler Roll-off: Die Frequenz, unterhalb derer ein bestimmter Prozentsatz (z. B. 85 %) der gesamten Spektralenergie liegt. Dies ist ein weiterer Indikator für die Spektralform und Helligkeit, der besonders nützlich ist, um zwischen tonalen und verrauschten Klängen zu unterscheiden.

Neutäitätskurve (Onset Strength Function): Diese Funktion hebt Momente signifikanter klanglicher Veränderungen oder „Neutäität” hervor, die oft mit der Wahrnehmung von Einsätzen oder Anschlägen in der Musik korrelieren. Spitzen in der Neutäitätskurve deuten auf mögliche Ereignisgrenzen hin.

Zero-Crossing-Rate (ZCR): Die Rate, mit der das Audiosignal sein Vorzeichen ändert (Null durchquert). Hohe ZCR-Werte deuten oft auf verrauschte, perkussive oder chaotische Klänge hin, während niedrige ZCR-Werte charakteristisch für eher tonale oder anhaltende Klänge sind.

Mel-Frequency Cepstral Coefficients (MFCCs): Diese werden häufig in der Audioanalyse verwendet, um die klanglichen oder strukturellen Eigenschaften eines Klangs darzustellen. Das Skript extrahiert 13 MFCCs und liefert so eine kompakte und wahrnehmungsrelevante Beschreibung der Klangfarbe.

Example of plot results of analysis of Karel Goeyvaerts’ Composition No 5

Ergebnisse und Verwendung

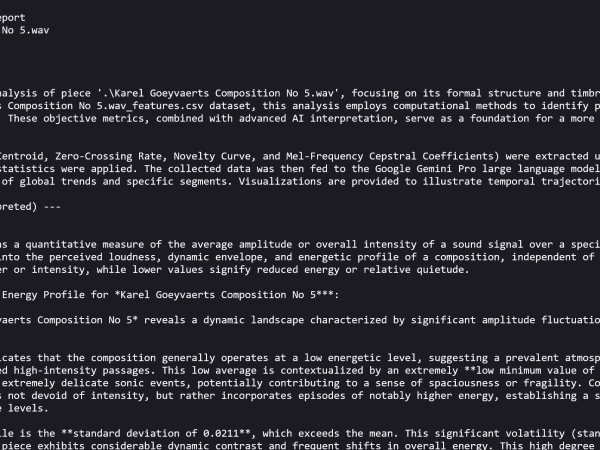

Alle extrahierten Merkmale werden zusammen mit einem entsprechenden Zeitvektor in einem Pandas-DataFrame organisiert und als CSV-Datei gespeichert. Dieses strukturierte Format erleichtert die weitere Analyse und Visualisierung. Daher fand ich es nützlich, Diagramme für RMS-Energie, Neuheitskurve, Spektralzentrum und Nulldurchgangsrate im Zeitverlauf zu erstellen. Diese Visualisierungen bieten einen schnellen, intuitiven Überblick über die dynamische, zeitliche und klangliche Entwicklung des Stücks. Außerdem habe ich einen Textbericht beigefügt, der mit Hilfe von Googles Gemini LLM erstellt wurde und narrative Beschreibungen der allgemeinen Trends und Merkmale für jedes extrahierte Merkmal im gesamten Stück enthält.

Lesen Sie den vollständigen Bericht: SEMA/Beispielausgabe: Karel Goeyvaerts Composition No 5.wav_Analysis_Report_Gemini

Durch die Analyse von Spitzen in der Neuheits-Kurve und signifikanten Veränderungen der RMS-Energie schlägt das Tool mögliche formale Unterteilungen oder strukturelle Verschiebungen innerhalb der Komposition vor. Der Benutzer kann auch bestimmte Zeitsegmente markieren, woraufhin SEMA eine detaillierte Interpretation erstellt und deren Merkmale mit den allgemeinen Trends des Stücks vergleicht. Dies ermöglicht eine gezielte Untersuchung bestimmter musikalischer „Momente” oder bestimmter Klangsegmente, wobei die menschliche Erfahrung in die Navigation durch das gesamte Musikstück einfließt.

Wann und wo kann SEMA helfen?

SEMA bietet eine vielseitige Reihe von Funktionen, die unter Berücksichtigung realer Anwendungsfälle für Musiker, Musikwissenschaftler und Forscher zusammengestellt wurden. Das Hauptziel besteht darin, quantifizierbare Daten zur Unterstützung qualitativer Beobachtungen elektroakustischer Stücke bereitzustellen, insbesondere solcher, für die keine traditionellen Partituren vorliegen. So ermöglicht es einen systematischen Vergleich der klanglichen Eigenschaften verschiedener Stücke, Komponisten oder Stilrichtungen. Es kann zur Identifizierung und Hypothesenbildung hinsichtlich formaler Unterteilungen und struktureller Gesten auf der Grundlage objektiver klanglicher Veränderungen verwendet werden, beispielsweise wie sich Klangfarben im Verlauf einer Komposition verändern und miteinander interagieren. Komponisten können auch ihre eigenen Werke analysieren, um objektives Feedback zu dynamischer Gestaltung, klanglicher Konsistenz und formaler Klarheit zu erhalten. Die Analyse bestehender Stücke (eigene oder fremde) kann zugrunde liegende Klangmuster oder Transformationen aufdecken, die zu neuen Kompositionsstrategien inspirieren oder Entscheidungen über Bearbeitung und Arrangement beeinflussen.

SEMA ist ein praktisches Werkzeug für Studierende, um Audio-Features und ihre musikwissenschaftliche Bedeutung kennenzulernen. Es ermöglicht ihnen, computergestützte Methoden direkt auf die Musikanalyse anzuwenden und die Ergebnisse sowie den dahinterstehenden Code zu beobachten, mit der Möglichkeit, diesen an ihre Bedürfnisse anzupassen. Die extrahierten Merkmale und KI-generierten Beschreibungen können als reichhaltige Metadaten für die Archivierung elektroakustischer Werke dienen, wodurch diese besser durchsuchbar und verständlicher werden. Außerdem eignet sich das Tool für die Analyse großer Sammlungen elektroakustischer Musik auf der Suche nach stilistischen Trends oder gemeinsamen klanglichen Merkmalen. Durch die Kombination von Audio-Merkmalsextraktion und kontextbezogener Interpretation ermöglicht SEMA den Nutzern, in die komplexen Klangwelten der elektroakustischen Musik einzutauchen und so die Lücke zwischen quantitativen Daten und einem nuancierten musikalischen Verständnis zu schließen.

Entdecken Sie: SEMA – Statistischer Elektroakustischer Musikanalysator

Milan Milojković

Milan Milojković (1986) ist ein interdisziplinärer Forscher (PhD in digitaler Musiktechnologie, Belgrad 2018) mit mehr als einem Jahrzehnt Erfahrung in der Lehre und akademischen Forschung in den Bereichen digitale Technologie, Musikanalyse und Mensch-Computer-Interaktion. Er entwickelt und analysiert klangbezogene Computerwerkzeuge und setzt die Ergebnisse und Errungenschaften in seiner Arbeit an der Akademie der Künste in Novi Sad (Serbien) und als Gründungsmitglied des Laptop Ensemble Novi Sad um. Er veröffentlicht regelmäßig Artikel über elektroakustische Musik und tritt mit LENS auf, wobei er theoretische Erkenntnisse in Live-Konzerten anwendet.

Artikelthemen

Artikelübersetzungen erfolgen maschinell und redigiert.

Milan Milojkovic

Milan Milojkovic