5 Minuten

Die Herausforderung von räumlichem Klang über Kopfhörer

Der Aufstieg von Virtual- und Augmented-Reality-Anwendungen hat das Interesse an binauralem Audio – also speziell für das Hören über Kopfhörer entwickeltem Klang – neu entfacht. Die Konvertierung bestehender mehrkanaliger elektroakustischer Kompositionen für die effektive Wiedergabe über Kopfhörer bleibt jedoch eine komplexe Aufgabe, die sowohl technische Präzision als auch künstlerisches Feingefühl erfordert.

Der 3D AudioSpace der Plattform Sounding Future veranschaulicht diese Herausforderung. Diese innovative Streaming-Plattform ermöglicht es Künstlern weltweit, ihre räumlichen Kompositionen in hochwertigem binauralem 3D-Audio zu präsentieren und so einem globalen Publikum ohne spezielle Hardware ein immersives Klangerlebnis zu bieten. Die Anpassung dieser Werke für Kopfhörer offenbart jedoch grundlegende Probleme bei der binauralen Wiedergabe, die seit Jahrzehnten bestehen.

Warum Kopfhörer anders klingen

Trotz technologischer Fortschritte gibt es bei der Wiedergabe über Kopfhörer nach wie vor inhärente Wahrnehmungsprobleme, die beim natürlichen Hören oder bei Lautsprechersystemen nicht auftreten.

In-Head-Lokalisierung tritt auf, wenn Geräusche eher aus dem Kopf des Zuhörers als aus externen Quellen zu kommen scheinen. Dieses Phänomen existiert nicht als binärer Zustand, sondern als Kontinuum, das das Hörerlebnis erheblich beeinflusst.

Front-Back-Confusion verhindert, dass Zuhörer unterscheiden können, ob Geräusche von vorne oder von hinten kommen. Beim natürlichen Hören werden diese Unklarheiten normalerweise durch subtile Kopfbewegungen aufgelöst, die die Zeitunterschiede zwischen vorderen und hinteren Geräuschen verändern.

Der Raumdivergenz-Effekt führt zu Wahrnehmungskonflikten, wenn binaurale akustische Informationen auf eine Umgebung hindeuten, während visuelle und propriozeptive Reize eine andere Umgebung suggerieren – beispielsweise wenn man in seinem Wohnzimmer sitzt und ein Konzert in einem Konzertsaal hört.

Diese Probleme führen zu einer unnatürlich breiten Klangbühne, auf der Klangquellen überwiegend von den Seiten zu kommen scheinen, während frontale Klänge nicht richtig nach außen übertragen werden und stattdessen im Kopf lokalisiert zu sein scheinen.

Technische Lösungen und ihre Grenzen

Es gibt mehrere Ansätze, um diese Herausforderungen zu bewältigen, die jedoch alle mit praktischen Einschränkungen verbunden sind.

Personalisierte Übertragungsfunktionen (HRTFs) modellieren individuell die Reflexionen von Ohren, Kopf und Oberkörper. Die umfangreichen Messverfahren sind jedoch nach wie vor zeitaufwändig und komplex, was eine breite Anwendung einschränkt.

Head-Tracking kann die Verwechslung von Quellen vorne und hinten teilweise verringern, indem es die Klangquellen bei Kopfbewegungen des Zuhörers stationär hält und so die Lokalisierung im Kopf reduziert. Einige Kopfhörer verfügen mittlerweile über diese Technologie, sie ist jedoch nicht universell verfügbar.

Binaurale Virtualisierung ist vielleicht der praktischste Ansatz. Bei dieser Methode werden Lautsprecher in einer Raumumgebung akustisch virtualisiert, wobei das Verhalten realer Lautsprecher in Hörräumen modelliert wird. Das Hinzufügen von raumakustischen Informationen zu ansonsten trockenen Klängen verbessert die Lokalisierung erheblich, da zusätzliche räumliche Hinweise bereitgestellt werden, die Klänge in einen akustischen Kontext einordnen.

Das Virtualisierungsdilemma

Die Implementierung der Virtualisierung wirft faszinierende Fragen zur künstlerischen Absicht auf. Sollte die ideale Hörumgebung ein hallfreier Raum ohne Reflexionen sein? Studiomonitore sind zwar für solche Räume optimiert, aber das Hören von Musik in völlig reflexionsfreien Umgebungen bringt seine eigenen Probleme mit sich.

Dies gilt insbesondere für Ambisonics – das Format, mit dem viele elektroakustische Komponisten arbeiten. Ambisonics profitiert von einem leichten Nachhall, der Spatial Aliasing kompensiert, das durch die mathematische Abschneidung der Spherical Harmonics in praktischen Implementierungen verursacht wird.

Es stellt sich die Frage: Verändert das Hinzufügen von virtuellem Nachhall zu Kompositionen, die bereits bestimmte virtuelle Räume enthalten, das Werk grundlegend? Dies entspricht der Art und Weise, wie jeder Konzertsaal den Klang eines Stücks beeinflusst – etwas, womit sich Komponisten seit jeher auseinandersetzen und wobei sie oft unbewusst die Eigenschaften des Veranstaltungsortes in ihren Kompositionsprozess einfließen lassen, man denke nur an frühe Chorwerke für große Kirchen und Kathedralen.

Ein Plädoyer für Ambisonics

Die Arbeit mit kanalbasierten Formaten stellt erhebliche Herausforderungen an die Standardisierung. Quadrophonische und oktaphonische Konfigurationen verfügen über keine einheitlichen Kanalnummerierungssysteme, und selbst etablierte Formate wie 5.1-Surround-Sound haben mehrere Konventionen mit unterschiedlichen Lautsprecherwinkeln.

Im Gegensatz dazu folgt das Ambisonics B-Format strengen Standards (AmbiX oder das ältere FUMA-Format) für die Kanalnummerierung und Normalisierung. Die Lautsprecherwinkel hängen vollständig von der Wiedergabekonfiguration ab und sind nicht im Format selbst festgelegt.

Die Konvertierung kanalbasierter Kompositionen in Ambisonics bietet zudem noch andere Vorteile: Sie ermöglicht die Wiedergabe auf verschiedenen Lautsprecheranordnungen, die über die ursprüngliche Konfiguration hinausgehen, die Integration von Ambisonics-spezifischen Effekten und die Möglichkeit größerer Sweet Spots, die bei Implementierungen höherer Ambisonics Ordnungen ein größeres Publikum aufnehmen können.

Der Konvertierungsprozess

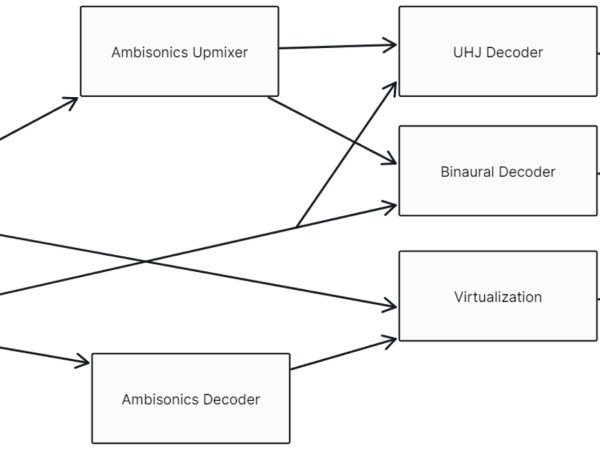

Die AudioSpace-Plattform bietet drei verschiedene Formate, die jeweils unterschiedlichen Hörszenarien dienen:

Stereo: verwendet das Ambisonics-UHJ-Format, ein hierarchisches Kodierungssystem aus den 1970er Jahren, das eine verbesserte Stereodarstellung bei gleichzeitiger Mono-Kompatibilität bietet.

Binaural: bei der binauralen Konvertierung werden spezielle Decoder verwendet, die Ambisonics-Audio mithilfe frequenzabhängiger Matrizen, die aus HRTFs abgeleitet werden, in zweikanaliges, für Kopfhörer optimiertes Audio umwandeln. Die Matrix kombiniert die in den Ambisonics-Kanälen enthaltenen räumlichen Informationen mit HRTF-Daten, die erfassen, wie Schall durch Kopf, Oberkörper und Ohren auf natürliche Weise verändert wird.

Binaural+: ergänzt den Konvertierungsprozess um virtuelle Raumakustik. Nach umfangreichen Tests wurde das Virtuoso-Plugin des Applied Psychoacoustic Lab aufgrund seiner Flexibilität und umfassenden Funktionalität ausgewählt. Die virtuelle Umgebung nutzt das kritische Hörraummodell von APL, das den Empfehlungen der ITU-R BS.1116-3 entspricht und einen guten räumlichen Eindruck ohne übermäßige akustische Reflexionen bietet.

Einblicke in die praktische Umsetzung

Der Konvertierungs-Workflow erfordert eine sorgfältige Abwägung der Dekodierungsmethoden und Lautsprecherkonfigurationen. Für Ambisonics-Kompositionen, die durch Virtualisierung verarbeitet wurden, wurde aufgrund seiner hohen Lautsprecherdichte das 26-Punkt-Lebedev-Design als virtuelles Lautsprecherarray gewählt.

Kanalbasierte Formate mussten vor der endgültigen Konvertierung in Ambisonics transkodiert werden. Die O7A Upmixer von Blue Ripple Sound erwiesen sich als besonders effektiv, insbesondere mit ihrem „Inferred”-Modus, der den Raum zwischen den codierten Quellen interpoliert, um eine kohärentere Darstellung des virtuellen Lautsprecherarrays zu erzielen.

Interessanterweise lieferte die Weiterleitung kanalbasierter Formate über Ambisonics oft bessere Ergebnisse als direkte matrixbasierte Konvertierungen und erleichterte gleichzeitig die zukünftige Implementierung von dynamischer Konvertierung, Head-Tracking und Streaming-Funktionen.

Ausblick

Da Virtual- und Augmented-Reality-Anwendungen die Verbreitung von binauralem Audio weiter vorantreiben, werden diese Konvertierungs - Herausforderungen nur noch an Bedeutung gewinnen. Die für Plattformen wie dem AudioSpace entwickelten Lösungen bieten wertvolle Rahmenbedingungen für zukünftige Implementierungen und verdeutlichen gleichzeitig das komplexe Zusammenspiel zwischen technischen Möglichkeiten und künstlerischem Ausdruck im Bereich des räumlichen Audios.

Da noch standardisierte Ansätze für die binaurale Konvertierung von Mehrkanalkompositionen fehlen, tragen Projekte wie dieses jedoch wesentliches praktisches Wissen für die Entwicklung künftiger Industriestandards bei und sorgen dafür, dass immersive elektroakustischen Musik auch weiterhin für Kopfhörerhörer weltweit zugänglich bleibt.

Link zum vollständigen Paper auf ResearchGate.

Jakob Gille

Jakob Gille begann seine formale Ausbildung an der HfM Dresden, wo er Komposition und Musiktheorie studierte. Er ist die treibende Kraft hinter Into Sound, einer Initiative, die seit ihrer Gründung im Jahr 2018 mehrere Konzerte in Berlin für 3D-Lautsprecher-Setups organisiert hat. In seinen Kompositionen und Forschungen spezialisiert er sich auf die Arbeit mit Ambisonics und immersiven Field Recordings. Derzeit absolviert er einen Masterstudiengang in Computermusik und Klangkunst am IEM Graz.

Artikelthemen

Artikelübersetzungen erfolgen maschinell und redigiert.

Jakob Gille

Jakob Gille